DeepSeek — это бесплатный универсальный ИИ-инструмент, доступный круглосуточно. Он как волшебный помощник: стоит только научиться им пользоваться — и вы вряд ли захотите с ним расставаться (как и с любым другим продвинутым ИИ-ассистентом).

Работая с DeepSeek, вы переходите от простого анализа к конструированию и связыванию промтов. Это как выход на новую орбиту мышления — невероятная скорость и эффективность в реализации идей. Всё, что нужно, — обратить внимание на DeepSeek, включить творческий режим и начать экспериментировать с запросами...

Хотите узнать, на что он способен? Например, давайте спросим у самого DeepSeek, как он может помочь в… скажем, нестандартных решениях или оптимизации задач.

---

DeepSeek: возможности и применение в реверс-инжиниринге, создании читов и трейнеров

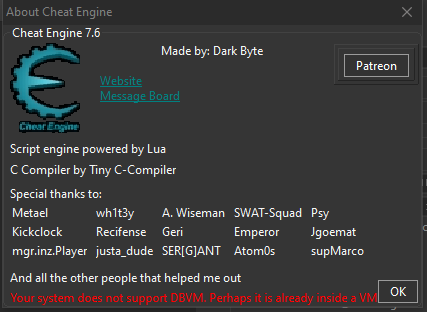

DeepSeek — это мощная AI-модель, способная анализировать код, помогать в реверс-инжиниринге, дизассемблировании и разработке игровых читов. Она может использоваться вместе с такими инструментами, как Cheat Engine, ReClass.NET, IDA Pro, Ghidra, x64dbg, для поиска уязвимостей, анализа памяти и автоматизации создания трейнеров.

---

1. Основные возможности DeepSeek

- Анализ кода: Чтение и объяснение ассемблерного (ASM), C++, C#, Python и др.

- Помощь в реверс-инжиниринге: Поиск функций, паттернов, расшифровка обфусцированного кода.

- Генерация кода для читов: Автоматическое создание DLL-инжекторов, хуков, патчей.

- Работа с памятью: Поиск указателей, анализ структур данных (например, в ReClass.NET).

- Отладка: Подсказки по использованию x64dbg, OllyDbg, IDA Pro.

---

2. Применение DeepSeek в создании читов

Cheat Engine: Поиск и модификация значений

DeepSeek может:

- Подсказать, как находить health, ammo, money через AOB (Array of Bytes)-сканирование.

- Генерировать Lua-скрипты для автоматизации поиска.

- Объяснять, как работать с Pointer Maps для обхода античитов.

Пример запроса:

"Как найти адрес здоровья в Cheat Engine и сделать pointer scan для динамического адреса?"

ReClass.NET: Анализ структур игровой памяти

- Помогает определить классы, структуры, массивы в памяти игры.

- Может предложить шаблоны для ReClass на основе дампа памяти.

Пример запроса:

"Как в ReClass.NET определить, что этот указатель ведёт на массив объектов игроков?"

IDA Pro / Ghidra: Дизассемблирование и патчинг

- Анализирует функции и помогает находить ключевые участки кода (например, проверку лицензии).

- Предлагает оптимальные байт-патчи (например, nop-инструкции для обхода проверок).

- Объясняет алгоритмы обфускации (VMProtect, Themida).

Пример запроса:

"Как в IDA Pro найти функцию, отвечающую за урон, и изменить её?"

Создание трейнеров (Trainers)

DeepSeek может помочь:

- Написать DLL для инжекции (C++/C#).

- Сгенерировать AutoHotkey-скрипты для биндов.

- Объяснить, как сделать графический интерфейс (например, на Python или C#).

Пример запроса:

"Как создать трейнер на C#, который изменяет значение здоровья в игре?"

---

3. Игровые движки и читинг

DeepSeek может анализировать Unity (Il2Cpp, Mono), Unreal Engine (GObjects, GNames), помогая:

- Находить UWorld, UPlayer в UE-играх.

- Расшифровывать DLL-файлы Unity (с помощью dnSpy).

- Обходить EasyAntiCheat (EAC), BattlEye.

Пример запроса:

"Как найти координаты игрока в Unity-игре с помощью Cheat Engine?"

---

Вывод

DeepSeek — это мощный AI-ассистент для реверс-инжиниринга, который ускоряет анализ игр, поиск уязвимостей и создание читов. Он особенно полезен в сочетании с:

Cheat Engine (поиск значений, Lua-скрипты)

ReClass.NET (анализ структур памяти)

IDA Pro/Ghidra (дизассемблирование, патчинг)

x64dbg/OllyDbg (отладка)

DLL-инжекторы и трейнеры (C++, C#, Python)

Если вам нужно взломать игру, создать чит или разобраться в коде — DeepSeek может стать вашим AI-напарником!

Важно: Используйте знания только в образовательных целях и для тестирования своих программ. Нарушение лицензионных соглашений игр может повлечь юридические последствия.